Probabilmente, la crisi di questi anni ha provocato qualcosa di molto simile ad un terremoto negli ambienti accademici. Improvvisamente, i modelli teorici e quelli matematici che, salvo rare eccezioni, avevano ben rappresentato la realtà dei mercati finanziari fino a quel momento, sono risultati incapaci di cogliere le ampie fluttuazioni che hanno caratterizzato le recenti cronache finanziarie. Già molti studiosi avvertivano il bisogno di superare il concetto dominante, che prevedeva una cieca fiducia nella campana di Gauss, ben consci della sua inadeguatezza a cogliere gli eventi “estremi”, cioè di ampiezza superiore a 3 deviazioni standard.

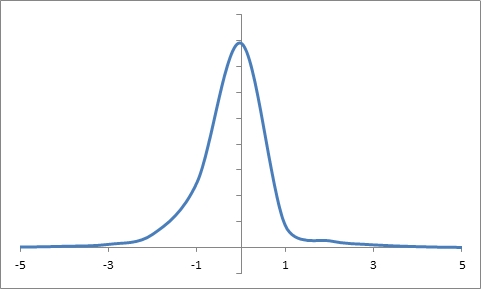

La distribuzione di probabilità di Gauss, detta anche normale, è infatti stata eletta dagli economisti del Novecento quale modello preferito per la rappresentazione della realtà finanziaria. In condizioni normali, ciò è indubbiamente vero: è estremamente improbabile che i prezzi subiscano variazioni superiori a determinati multipli della deviazione standard. Tuttavia, i grandi guadagni e le grandi perdite si fanno proprio su quelle variazioni che esulano dal 95% (o 99%, in alcuni casi) di probabilità previsto dai modelli basati sulla distribuzione di Gauss.

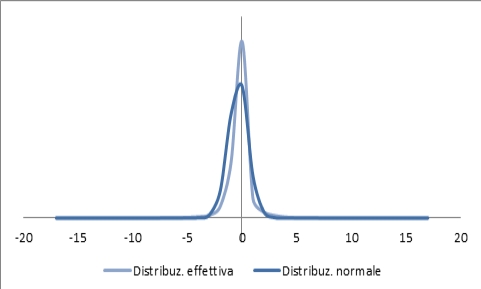

Alla luce di quanto detto, la distribuzione dei rendimenti di un qualunque strumento finanziario quotato dovrebbe, secondo la teoria finanziaria tradizionale, seguire una distribuzione normale. Sono tuttavia numerose, in letteratura, le critiche a questo modello quale rappresentazione ottimale della distribuzione dei rendimenti. In particolare, spesso viene criticata la presenza di code spesse nelle distribuzioni effettive: in altri termini, raffigurando su un istogramma la frequenza dei rendimenti in un dato periodo, le variazioni estreme parrebbero capitare più spesso di quanto non preveda la distribuzione normale.

Prendendo ad esempio i rendimenti giornalieri dell’indice statunitense S&P 500 tra il 1950 e il 2008, il grafico della relativa distribuzione è il seguente:

Figura 1 - Distribuzione cumulativa delle frequenze dei rendimenti dell'indice S&P 500 tra il 1950 e il 2012.

Apparentemente, il grafico sembra assumere la forma a campana tipica della distribuzione normale di cui sopra. Sovrapponendolo con quello che risulterebbe se i rendimenti fossero distribuiti secondo una distribuzione perfettamente gaussiana, si può notare maggiormente la differenza:

Figura 2 - Confronto tra la distribuzione normale e quanto effettivamente verificatosi.

Le code sono lievemente più spesse e i dati si concentrano in misura inferiore rispetto alla media di quanto previsto dal modello, che di per sé sembrerebbe suggerire una lieve incoerenza.

I dati che hanno generato il grafico sono i seguenti:

|

Multipli di σ |

α |

N dati |

% su totale |

Z |

N normale |

|

0 |

1,2591% |

13673 |

86,4778% |

84,1345% |

14035,3 |

|

1 |

1,2591% |

2138 |

13,5222% |

15,8655% |

2646,7 |

|

2 |

2,1723% |

558 |

3,5292% |

2,2750% |

379,5 |

|

3 |

3,0854% |

184 |

1,1637% |

0,1350% |

22,5 |

|

4 |

3,9986% |

85 |

0,5376% |

0,0032% |

0,5 |

|

5 |

4,9117% |

44 |

0,2783% |

0,0000% |

0,0 |

|

6 |

5,8249% |

25 |

0,1581% |

0,0000% |

0,0 |

|

7 |

6,7380% |

14 |

0,0885% |

0,0000% |

0,0 |

|

8 |

7,6512% |

8 |

0,0506% |

0,0000% |

0,0 |

|

9 |

8,5643% |

7 |

0,0443% |

0,0000% |

0,0 |

|

10 |

9,4775% |

3 |

0,0190% |

0,0000% |

0,0 |

|

11 |

10,3906% |

3 |

0,0190% |

0,0000% |

0,0 |

|

12 |

11,3038% |

2 |

0,0126% |

0,0000% |

0,0 |

|

13 |

12,2169% |

1 |

0,0063% |

0,0000% |

0,0 |

|

14 |

13,1301% |

1 |

0,0063% |

0,0000% |

0,0 |

|

15 |

14,0432% |

1 |

0,0063% |

0,0000% |

0,0 |

|

16 |

14,9564% |

1 |

0,0063% |

0,0000% |

0,0 |

|

17 |

15,8695% |

1 |

0,0063% |

0,0000% |

0,0 |

La prima colonna contiene i multipli della deviazione standard che sul grafico popolavano l’asse orizzontale, mentre α rappresenta la soglia utilizzata per il conteggio della relativa distribuzione. A ogni valore nella colonna α dalla seconda riga alla diciassettesima viene associato così il numero di rendimenti superiori, in valore assoluto, a tale soglia; nella prima riga, corrispondente a un multiplo pari a zero nella prima colonna, vengono invece conteggiati i valori compresi tra la media e la deviazione standard. I dati così ottenuti vengono poi rapportati al totale dei rendimenti raccolti, ovvero 15811, per ottenere una serie di percentuali rappresentative della probabilità che le successive variazioni siano comprese all’interno di tale range. Le ultime due colonne, invece, rappresentano la distribuzione che si avrebbe applicando la media e la deviazione standard del periodo su una classica distribuzione normale.

Alla luce di quanto mostrato dalla tabella, è evidente la differenza in termini di code: mentre la distribuzione normale non avrebbe previsto rendimenti superiori al 4,9117%, se ne sono verificati ben 44. Sono invece stati 14 quelli oltre il 6,7380%, ignorati anch’essi dal modello standard. Anche scendendo ad appena 3 multipli di σ, vale a dire una soglia del 2,2655%, i risultati sono radicalmente diversi: se la normale avrebbe previsto 22 riscontri, la realtà dei fatti ne ha contati 184.

Le assunzioni del test potrebbero avere implicazioni per certi versi importanti. Per ben 53 volte, infatti, il modello non ha previsto variazioni superiori al 4,9117% in valore assoluto, rappresentanti opportunità di guadagno e potenziali perdite di dimensioni considerevoli.

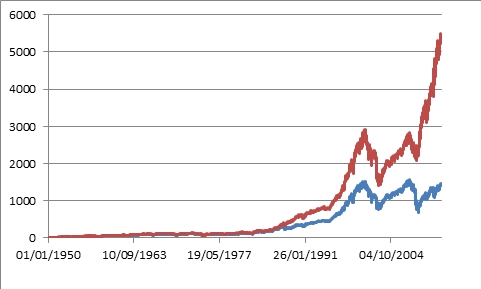

Per rendere meglio l’idea, ho costruito il seguente grafico, che confronta l’andamento effettivo dell’indice (linea blu) con quello che si sarebbe verificato in assenza delle famigerate variazioni superiori a 5 deviazioni standard (linea rossa), in valore assoluto:

C’è una bella differenza, direi. La grande differenza tra i due andamenti mostra anche un altro aspetto interessante: ho eliminato dalla distribuzione tutte le variazioni, positive e negative, superiori a 5 deviazioni standard. Un differenziale così elevato sembrerebbe suggerire una prevalenza piuttosto netta dei tracolli, piuttosto che dei momenti di alta pressione sugli acquisti. Più che di guadagni clamorosi mancati, si può quindi parlare di ingenti perdite inattese.

Quanto descritto in queste righe è solo un esempio, ma a mio parere rende bene l’idea di quanto siano importanti le differenze tra la realtà dei mercati e quanto descritto dalla teoria. Non è nulla di nuovo, in quanto, come già detto in precedenza, si tratta di problemi già noti agli ambienti accademici. La mancanza (almeno fino agli ultimi anni) di un approccio alternativo ha tuttavia quantomeno ritardato la messa da parte dell’attuale impianto teorico.

Esiste un approccio alternativo? Secondo me sì, ma lo mostrerò a tempo debito, nelle prossime puntate.